Ist es angesichts der unerreichten, einst lautstark verkündeten Verheißungen und neuartigen Herausforderungen, an der Zeit, ein neues Leitbild für die Künstliche Intelligenz in Erwägung zu ziehen?

Die bislang wichtigsten Technologien: Big Data und Deep Learning

In den letzten Jahren standen Big Data und Deep Learning eine Zeit lang im Mittelpunkt der Debatte unter den Praktikern der Datenwissenschaft und des Data Engineering und fanden auch in der breiten Öffentlichkeit große Beachtung, da sie versprachen, zentrale Aspekte unseres Alltags zu automatisieren und zu verändern, wie etwa selbstfahrende Autos oder autonome Serviceroboter.

Big Data und Deep Learning stellen zwar eine Reihe sehr einflussreicher Technologien dar, haben aber auch ihre Tücken und die meisten der selbstbewusst gesetzten Ziele sind noch weit entfernt.

Big Data ist das Bestreben, riesige Mengen aller Arten von Daten aus verschiedenen Quellen zu sammeln und sie entsprechend zu strukturieren und zu speichern. Obwohl dies meist sehr ressourcenintensiv ist, werden es als wichtige Voraussetzung für Deep Learning angesehen, da es den notwendigen Basisinput für die Fütterung der leistungsstarken, aber datenhungrigen neuronalen Netze während ihrer anfänglichen Trainingsphasen liefert.

Deep Learning ist im Wesentlichen eine Methode zum Trainieren eines Netzes künstlicher Neuronen, um Muster in den Daten zu erkennen, mit denen wir es füttern. Im Allgemeinen ist es am besten geeignet, wenn eine Fülle von Daten für das Training zur Verfügung steht und die zu lösende Aufgabe auf eine Frage mit recht einfacher Logik eingegrenzt werden kann, z. B. „Ist auf diesem Bild eine Person oder ein Auto zu sehen?“.

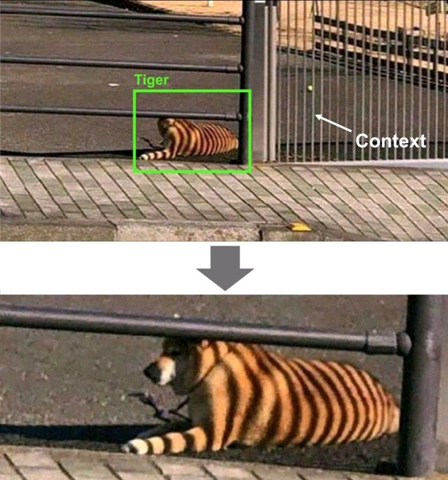

Doch selbst bei scheinbar einfachen Fragen, den ausgeklügeltsten Architekturen neuronaler Netze, vielen Daten und unbegrenzter Rechenleistung gibt es immer noch viel Raum für falsche Schätzungen. Das liegt daran, dass die KI in ihrem derzeitigen Zustand in der Regel nicht in der Lage ist, den tatsächlichen Kontext zu erfassen, und selbst große Datensätze können oft nicht die gesamte natürliche Varianz berücksichtigen, die in der Verteilung der „echten“ Daten zu finden ist, mit denen das Modell in der Produktion konfrontiert wird. Aus diesem Grund wimmelt es im Internet nur so von Memes wie dem folgenden, das scherzhaft auf die manchmal komischen Fehler anspielt:

Diese Unzulänglichkeiten des Deep Learning können bei unkritischen, verbrauchernahen Anwendungen wie Chatbots oder Empfehlungssystemen als leicht amüsant oder als bloßes Ärgernis betrachtet werden. Sie können jedoch neue potenzielle Risiken mit sich bringen, wenn sie unreflektiert für kritische Entscheidungen in Bereichen wie der Luftfahrt, dem Gesundheitswesen oder der Strafverfolgung eingesetzt werden.

Die natürliche Komplexität großer neuronaler Modelle macht das Auftreten dieser Fehler oft unvorhersehbar und schwer zu beheben. Trotz der jüngsten Durchbrüche auf dem Gebiet der erklärbaren KI besteht nach wie vor ein erheblicher Kompromiss zwischen Leistung (die durch zunehmende Komplexität erreicht wird) und Interpretierbarkeit eines KI-Modells. Aufgrund der inhärenten Unschärfe der Technologie wird wahrscheinlich immer ein nicht zu vernachlässigendes Restrisiko verbleiben, selbst wenn wir uns an einen methodisch soliden Ansatz halten, der übrigens nicht annähernd so häufig verfolgt wird, wie man es sich wünschen würde, wie bei den meisten vergeblichen Versuchen, KI für die Diagnose von Covid-19 einzusetzen.

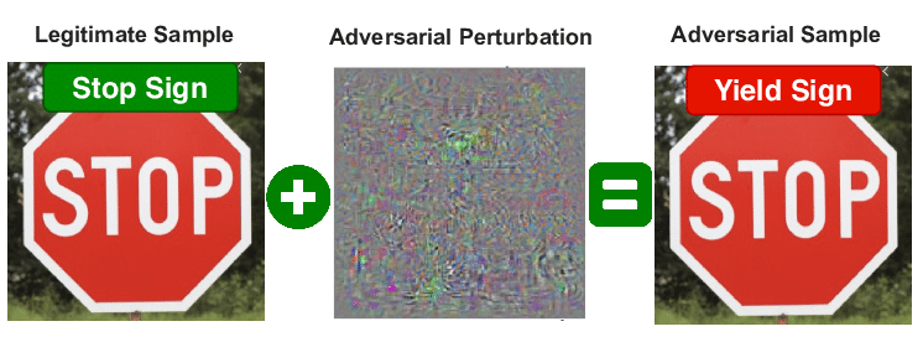

Ein weiterer Grund zur Sorge ist, dass diese nicht stringente Tendenz von böswilligen Akteuren aktiv ausgenutzt werden kann, um die Leistung eines Modells durch gezielte Manipulation der ihm vorgelegten Daten zu beeinträchtigen (adversarial attack = feindlicher Angriff).

Die nachstehende Abbildung zeigt ein Beispiel für eine adversarial attack auf eine Bilderkennungs-KI, wie sie unter anderem auch in selbstfahrenden Autos eingesetzt wird, bei dem das Hinzufügen einer geringen Menge an verpixeltem Rauschen, das für das menschliche Auge nicht wahrnehmbar ist, zu einer völligen Fehlinterpretation des angezeigten Bildes führt.

Selbst unter den günstigsten Umständen bietet Deep Learning per se also nur dann eine brauchbare Lösung, wenn wir nur ungefähre Ergebnisse benötigen und das Fehlen absoluter Präzision oder Zuverlässigkeit tolerierbar ist.

Wenn wir die Potenziale der Künstlichen Intelligenz für anspruchsvollere Szenarien erschließen wollen, wenn Daten und Rechenleistung knapp sind oder bestimmte Fehler unbedingt vermieden werden müssen, dann müssen wir über das derzeit vorherrschende Paradigma von Big Data und Deep Learning hinaus denken. Um in diese Bereiche vorzudringen, müssen wir alternative Techniken in Betracht ziehen, anstatt uns nur auf die immer komplizierter werdende Optimierung eines engen Satzes von Tools zu konzentrieren, die manchmal nicht einmal die beste Lösung für einen bestimmten Zweck darstellen.

Die (nicht mehr ganz so) neuen Technologien der Stunde: Smart Data und hybride Modelle

Das bedeutet natürlich nicht, dass Deep Learning nicht mehr in Frage kommt, denn wir können viele seiner unbestreitbar beeindruckenden Errungenschaften der letzten Jahre als Grundlage nutzen, auf der wir in einigen Fällen aufbauen können, in denen die ursprüngliche Datenmenge nicht ausreicht, um ein neues Modell von Grund auf zu trainieren. Dank des ausgeprägten Open-Source-Gedankens und des Wissensaustauschs innerhalb der Community können wir heute für eine große Anzahl von Anwendungsfällen auf eine Vielzahl von bereits trainierten Modellen zurückgreifen.

Zunächst wählen wir ein geeignetes Modell aus, dann nehmen wir geringfügige Anpassungen vor und stimmen es mit einem kleineren, aber gut konzipierten Datensatz auf einen bestimmten Zweck ab, z. B. eine bildbasierte Qualitätssicherungsprüfung in der Fertigung oder das Hinzufügen von Bewusstsein für ein bestimmtes Vokabular in einem Modell zur Analyse der Stimmung in Texten. Auf diese Weise sind nur geringfügige Änderungen an der Codebasis erforderlich, und der größte Teil des Wertes wird durch Aktivitäten generiert, die sich um die durchdachte Zusammenstellung eines Datensatzes drehen, der gerade genug und genau die richtige Art von Daten enthält, die erforderlich sind, damit das Modell unsere Anforderungen erfüllen kann. Dieser Ansatz kann als Smart Data oder datenzentrierte KI bezeichnet werden.

Je nach Problem, das wir zu lösen versuchen, können wir erstaunlich gute Ergebnisse erzielen, wenn wir datenzentrierte KI mit verschiedenen Ansätzen aus anderen Disziplinen kombinieren, z. B. mit statistischer Inferenz oder First-Principles-Modellen (Physik, Biologie, Chemie etc). Um eine angemessene Grundlage für unser Modell zu gewährleisten, können wir es mit Leitlinien aus vordefinierten Regeln und Schwellenwerten ausstatten oder es mit Heuristiken anreichern, die aus den wertvollen Beiträgen erfahrener Fachleute abgeleitet werden.

Ein weiterer vielversprechender Ansatz ist das „neuronal-symbolic cognitive Reasoning“, das die KI systematisch um die algebraische Manipulation symbolisch dargestellter Entitäten erweitert. Obwohl ihre hybride Natur oft unerkannt bleibt, sind Modelle, die auf zusammengesetzten Architekturen aufbauen, allgegenwärtig und wahnsinnig erfolgreich. Selbst die Google-Suche, die vermutlich beliebteste Suchmaschine der Welt, basiert auf einer pragmatischen Mischung aus symbolmanipulierenden Techniken und Deep Learning.

Was bedeutet das für Sie als kleines und mittleres Unternehmen?

Eine gute Nachricht: Die Grundidee von Smart Data und Hybridmodellen besteht darin, dass Sie die potenziellen Vorteile der KI nutzen können, ohne unbedingt Petabytes an ML-fähigen Daten zu besitzen oder Ihr ganzes Vertrauen in ein unberechenbares Blackbox-System setzen zu müssen.

Als KI-Venture Builder, der sich auf Co-Innovation für KMUs in Europa spezialisiert hat, verfügt die DDG über eine lange Erfahrung in diesem Bereich. Unsere Partner verfügen in der Regel weder über große Datenmengen noch über die Ressourcen, um teure Big-Data-Architekturen für das Training überdimensionaler Deep-Learning-Modelle aufzubauen, nur um die Machbarkeit eines möglichen Venture Case zu testen. Daher verfügt die DDG über ein praxiserprobtes Set an Methoden zur Identifizierung von potentiellen Anwendungsfällen und Anforderungen sowie zur Bestimmung, welche Ansätze für die höchste Erfolgschance kombiniert werden müssen.

Bleiben Sie also dran! Im nächsten Beitrag dieser Serie werden wir uns näher damit befassen, wie man die Potenziale hybrider Modelle systematisch auslotet und wie man sie in der Praxis nutzen kann.

Sie möchten mehr über das Thema erfahren?

Philipp Redlinger

Head of Innovation